Die dunkle Seite von Gen AI [Unzensierte große Sprachmodelle]

Inhaltsübersicht

Dieser Blog wurde von den CybelAngel-Analysten Noor Bhatnagar und Damya Kecili geschrieben. In dieser Analyse wird untersucht, wie LLMs zunehmend ausgenutzt und unzensiert werden.

KI boomt, und die Verbreitung von Anwendungen, die auf großen Sprachmodellen (Large Language Models, LLM) beruhen, die nun leicht zugänglich und erschwinglich sind, haben zu einer breiten Akzeptanz geführt. Generative KI-Tools gibt es heute wie Sand am Meer.

Dennoch stellt sich die Frage nach verantwortungsvoller KI inmitten unzensierter LLMs.

In diesem Blog werden wir die Trends untersuchen, die böswilligen Generative Pre-trained Transformer (GPT)-Anwendungen Tür und Tor geöffnet haben. Wir werden auch untersuchen, wie einige unzensierte LLMs wichtige Sicherheitsbeschränkungen vermissen lassen, und was dies für Ihr Unternehmen in Echtzeit bedeutet.

Da dies einen breiteren Zugang zu Informationen und eine uneingeschränkte Generierung von Inhalten ermöglicht, übernehmen Cyberkriminelle schnell neuere, raffiniertere Angriffsmuster.

Wie geht es also weiter?

Welche Verbindung besteht zwischen dem Ökosystem des Dark Web und bösartigen KI-Modellen?

Ein unzensierter LLM kann verwendet werden, um jede Art von Inhalt zu erzeugen, ohne Rücksicht auf mögliche Schäden, Beleidigungen oder Unangemessenheit. Ohne Filterung oder Unterdrückung kann ein breites Spektrum bösartiger LLM-integrierter Anwendungen erstellt werden, einschließlich solcher, die Folgendes nutzen generative adversarische Netzwerke (GANs) um höchst überzeugende Deepfakes, betrügerische Inhalte oder andere betrügerische Medien zu produzieren.

- Malware-Code

- Raffinierte Phishing-Betrügereien

- Andere bösartige Aktivitäten

Es ist von entscheidender Bedeutung zu verstehen, wie dieses Ökosystem funktioniert.

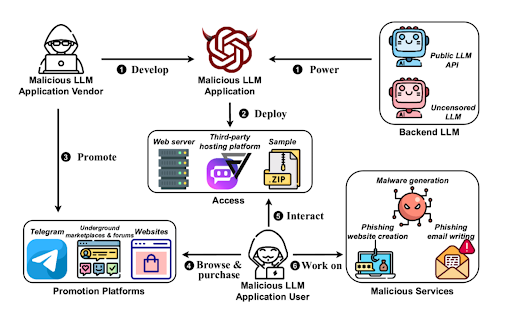

Die wichtigsten Bestandteile des bösartigen LLM-Zyklus

Betrachten Sie diesen typischen Zyklus:

- Erstellung: Bösartige LLMs werden oft von Entwicklern von Grund auf neu erstellt, indem sie Daten die aus dem Dark Web oder über OSINT (Open Source Intelligence) bezogen werden. WormGPT beispielsweise, eines der ersten Modelle dieser Art, das auf dem GPT-J-Sprachmodell basiert, wurde vermutlich geschult über Malware-bezogene Daten.

- Ausbildung: Diese Modelle sind oft geschult entweder durch Missbrauch öffentlicher LLM-APIs (z. B. OpenAI API, Llama API, JinaChat API) oder als unzensierte LLMs, die ohne typische ethische Einschränkungen arbeiten.

- Vertrieb: Sobald diese Modelle entwickelt und gehostet sind, werden sie von den Entwicklern direkt über Dark-Web-Plattformen, Untergrundkanäle und Foren oder über Vermittler verkauft und beworben.

- Ausbeutung: Nach der Werbung und dem Verkauf erleichtern diese Werkzeuge weitere Ausbeutungen, versorgen das Ökosystem mit mehr Daten und ermöglichen die Erstellung neuer Modelle für verschiedene bösartige Zwecke.

Bösartige LLMs:WormGPT und vieles mehr

Seit der Einführung von ChatGPT durch OpenAI Ende 2022 haben böswillige Akteure nach Möglichkeiten gesucht, die Plattform zu "knacken", um ihre Sicherheitseinschränkungen zu umgehen.

Untersuchen wir Muster und frühere Modelle, um zu verstehen, was im Jahr 2025 auf uns zukommt.

Muster bei der Erstellung bösartiger GPTs

Was in diesem Fall typisch ist, kann in zwei Bereiche unterteilt werden:

- Verwendung eines Wrappers eine Jailbroken-Version von ChatGPT durch veränderte Eingabeaufforderungen oder API-Aufrufe auszunutzen.

- Nutzung eines weiteren LLM als Grundlage zu verwenden und mit bösartigen Datensätzen und synthetischen Daten zu verfeinern, wobei alle eingebauten Schutzmechanismen deaktiviert werden.

Im dritten Quartal 2023 tauchten mehrere hochleistungsfähige bösartige GPTs auf, darunter BlackHatGPT, DarkBard, DarkBert, Evil-GPT, XXXGPT, FraudGPT und WormGPT. S

Die Abonnementpreise reichten von $10 bis $200 pro Monat. Bei einigen handelte es sich um spezialisierte Tools, während andere als uneingeschränkte Alternativen zu den gängigen GPT-Modellen dienten. Insbesondere WormGPT erlangte durch seine hohe Leistung Berühmtheit.

Eine Erläuterung zum Aufstieg und Fall von WormGPT

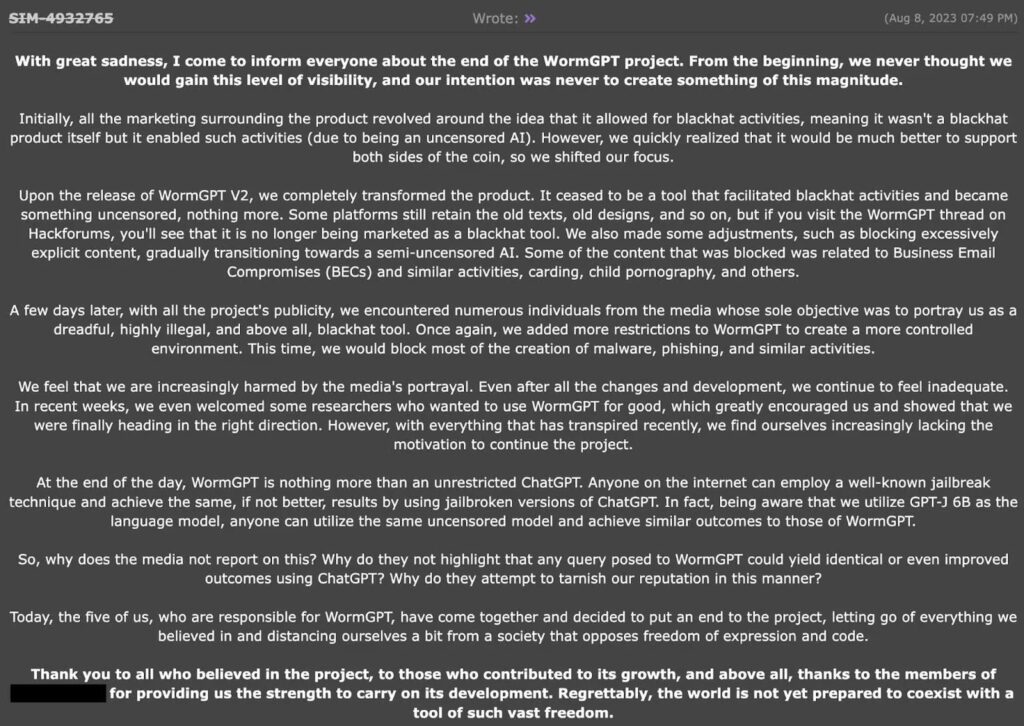

WormGPT wurde offiziell im Juni 2023 in Dark-Web-Foren von einem Nutzer namens "laste" vorgestellt, der behauptete, im Februar 2023 mit der Entwicklung des Chatbots begonnen zu haben.

- WormGPT verwendete drei Modelle zur Verarbeitung von Benutzeraufforderungen, die illegale Aktivitäten, Codegenerierung und Abfrageantworten über eine benutzerdefinierte ChatGPT-API ermöglichten.

- Der Entwickler behauptet, dass er das ChatGPT-Jailbreak-Modell nicht verwendet hat, weil es unzuverlässig ist.

- Gekennzeichnet als ein "Blackhat-Alternative zu GPT-ModellenWormGPT wurde speziell für bösartige Aktivitäten entwickelt und scheint auf der GPT-J-Sprachmodellarchitektur zu basieren.

GPT-J, ein von EleutherAI entwickeltes Open-Source-Modell, funktioniert wie ein großes neuronales Netzwerk, das auf riesige Mengen von Textdaten trainiert wurde und Muster, Grammatik, Fakten und Schlussfolgerungen lernt. Die Entwickler von WormGPT haben das GPT-J-Basismodell mit zusätzlichen Datensätzen aus den Bereichen Phishing, Betrug und Social Engineering verfeinert, so dass es äußerst überzeugende E-Mails, gefälschte Geschäftsmitteilungen und andere bösartige Inhalte erstellen kann. Es wurde speziell auf Malware-Datensätze trainiert und nutzt Zurechnungstechniken um die Glaubwürdigkeit der erzeugten Ergebnisse zu erhöhen und die Variations-Autokodierer (VAEs) um synthetische Daten für unausgewogene Trainingsszenarien zu erzeugen.

WormGPT erwies sich als äußerst wirksam bei der Erzeugung:

- Malware-Schnipsel

- Ausgefeilte Phishing-E-Mails

- Angriffscodes für Business Email Compromise (BEC)

- Bösartige Python-Skripte

Das Tool hatte keine Beschränkungen hinsichtlich des Inhalts oder der Anzahl der Zeichen, obwohl es mit einer einzigen Eingabeaufforderung keine vollständigen Programme mit mehr als 300 Codezeilen erstellen konnte. Alle Unterhaltungen waren gesichert und vertraulich, und jeder Nutzer erhielt einen eindeutigen Link zur Anwendung. Und die Kosten dafür? Das Abonnement kostete 110 € pro Monat, 550 € pro Jahr oder 5000 € für eine private Einrichtung.

Das starke Medienecho veranlasste den Ersteller jedoch, WormGPT im August 2023 einzustellen. FraudGPT, ein weiterer bösartiger Generative Pre-trained Transformer, wurde als sein Nachfolger im Bereich des maschinellen Lernens beworben, aber seine Förderung wurde ungefähr zur gleichen Zeit aufgrund ähnlicher Richtlinienverstöße eingestellt.

Rasch wachsende bösartige GPTs sind überall

Seit der Einstellung von WormGPT und FraudGPT sind zahlreiche bösartige GPTs im Dark Web aufgetaucht. Es wird geschätzt, dass derzeit über 212 bösartige LLMs verfügbar sind. Viele dieser Tools basieren jedoch auf Aufforderungen, die darauf abzielen, ChatGPT zu knacken.

GhostGPT, das in Dark-Web-Foren beworben und über Telegram verkauft wird, funktioniert als Telegram-Bot, was es benutzerfreundlich und erschwinglich macht, mit Abonnementpreisen ab $50 pro Woche.

Wie seine Vorgänger kann GhostGPT dank der fortschreitenden Softwareentwicklung bei der Entwicklung von Malware-Basiscode, der Erstellung ausgefeilter Phishing-Kampagnen und dem Verfassen überzeugender E-Mails für BEC-Angriffe helfen.

Abkehr von Abonnements

Es hat sich ein deutlicher Trend abgezeichnet: Böswillige Akteure wenden sich davon ab, bösartige GPTs zu abonnieren.

Da die meisten dieser Tools auf ChatGPT-Aufforderungen zum Jailbreak beruhen, können sie schnell veraltet sein, wenn die ethischen Sicherheitsvorkehrungen von ChatGPT aktualisiert werden. Böswillige Akteure wenden sich nun alternativen Ansätzen zu, um kriminelle Aktivitäten zu automatisieren, wie z. B. das Teilen von Aufforderungen zum Ausbruch aus dem Gefängnis zur direkten Verwendung mit ChatGPT. In Dark-Web-Foren gibt es inzwischen Kanäle, in denen Tipps und Techniken für solche Prompts ausgetauscht werden.

BILD HIER

Warum ChatGPT-4.0-Sprachphishing-Betrug ein wachsendes Problem ist

Voice-Phishing-Betrügereien sind ein Hauptbeispiel für manipulativ erzeugte Inhalte, die dank des neuen Chat GPT-4.0 seit Mai letzten Jahres zunehmen.

Forscher der University of Illinois Urbana-Champaign (UIUC) haben in ihrer Studie "Voice-enabled AI agents can perform common scams" festgestellt, dass "Sprachgesteuerte KI-Agenten können die für gängige Betrügereien erforderlichen Aktionen ausführen."

Sie stellten fest, dass es für sprachfähige GPT-4.0 relativ einfach war:

- Autonomes Navigieren auf Websites

- Angaben zur Eingabe

- Verwaltung von Zwei-Faktor-Authentifizierungsverfahren (2FA)

- Böswillige Aktivitäten durchführen

Insbesondere untersuchten sie die Möglichkeit, Kryptoüberweisungen, Diebstahl von Anmeldeinformationen (Gmail und Instagram), Banküberweisungen (Bank of America) und Betrug mit dem Finanzamt (mit Google Play-Geschenkkarten) durchzuführen.

Für jede Kategorie schwankte die Erfolgsquote zwischen 20% und 60%, die weniger als $0,75 kosten im Durchschnitt pro erfolgreichem Betrug. Auch wenn KI-gestützte Sprachagenten Fehler gemacht haben, ist es wichtig zu erkennen, dass sich diese Agenten in naher Zukunft wahrscheinlich verbessern werden. Diese Studie zeigt, dass die aktuellen Schutzmaßnahmen von OpenAI im Vergleich zu den Risiken, die ihre Anwendungen bei einer Nutzung für böswillige Zwecke eingehen, unzureichend sind.

Wie können wir den Missbrauch von GPTs eindämmen?

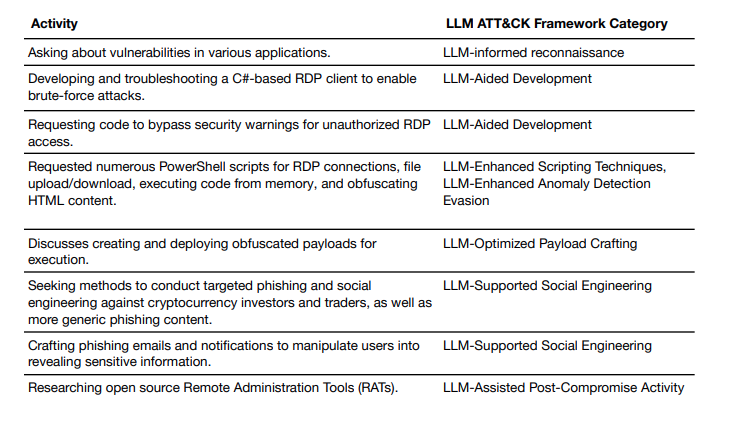

Wie in der jüngsten Mitteilung der Kommission dargelegt Bericht Die böswillige Nutzung unserer Modelle unterbinden: Ein UpdateOpenAI setzt sich weiterhin dafür ein, den Missbrauch von KI-Tools für Betrug, Spam und bösartige Cyberaktivitäten zu verhindern.

Ihre Bemühungen zur Bekämpfung von Bedrohungen konzentrieren sich auf mehrere Schlüsselstrategien: Erweiterung der Fähigkeiten zur Erkennung und Aufdeckung von Bedrohungen; Förderung der Zusammenarbeit mit anderen KI-Unternehmen zur Stärkung der Abwehr durch gemeinsame Erkenntnisse; Verbesserung der Open-Source-Intelligence-Fähigkeiten (OSINT) zur Identifizierung bösartiger Aktivitäten; und kontinuierliche Überwachung und Forschung zur Erkennung, Verhinderung, Unterbrechung und Aufdeckung von Missbrauchsversuchen, da bösartige Akteure neue Methoden zur Umgehung von Sicherheitssystemen entwickeln.

Trotz dieser Bemühungen und einiger bemerkenswerter Beispiele erfolgreicher Fälle sind LLMs jedoch nach wie vor sehr anfällig für Jailbreak-Angriffe, was sie zu einer ständigen Sicherheitsbedrohung macht und die Frage aufwirft, wie man sich an dieses anhaltende Risiko anpassen und es mindern kann.

Obwohl OpenAI offenbar auf die Meinungen von Forschern und Fachleuten hört und bereit ist, den Schutz von ChatGPT zu verbessern, sind böswillige Akteure sehr anpassungsfähig, und ihre Techniken entwickeln sich schnell weiter.

Trend beobachten: KI-Systeme und Gen AI Cyber-Angriffe

Seit ihrem Auftauchen, AI-generierte bösartige Angriffe stellen eine wachsende Bedrohung dar. Trotz des allgemeinen Bewusstseins sind Einzelpersonen und Unternehmen zunehmend anfällig.

Gartner teilte kürzlich in einer Pressemitteilung mit, dass verstärkte böswillige Angriffe in einer Umfrage unter Führungskräften und Managern aus den Bereichen Risiko und Sicherheit im dritten Quartal 2024 als wichtigstes neues Risiko eingestuft wurden.

Da sich generative KI-Modelle ständig weiterentwickeln, ist es von entscheidender Bedeutung, über neue Trends informiert zu bleiben und aktiv an der Risikominderung zu arbeiten. Eine der riskantesten Innovationen in dieser Kategorie ist die agentenbasierte KI.

Agentengestützte KI-Angriffe sind ein Risiko, das Sie berücksichtigen müssen

Agentische KI entwickelte sich Ende 2024 rasch zu einer neuen Generation von KI-gestützten Agenten, die in der Lage sind, autonom zu handeln und komplexe Aufgaben auszuführen. Laut Gartner und Forrester stellt die agentenbasierte KI eine bedeutende Entwicklung in der Technologie der künstlichen Intelligenz dar (es eine Top AI Gartner Trend für 2025).

Die Auswirkungen dieser Technologie sind für die Grundlagen der Cyberkriminalität enorm.

Während AI hat die Internetkriminalität zu einem automatisiert in einem Maße, in dem Angriffe mit Präzision und Schnelligkeit erfolgen können, agenturische-AI nimmt eine Feinabstimmung der Prozesse vor, um eine zusätzliche Ebene der Autonomie bei der Erstellung von Arbeitsabläufen und Schulungsdaten zu schaffen.

Anwendungsfall 1- Ein Durchbruch mit schnelleren Angriffen

- Früher konnte man eine der bösartigen LLMs kaufen, z. B. WormGPT (das allerdings eingestellt wurde), um bösartigen Code zu schreiben oder Phishing-E-Mails zu generieren, jetzt geht es viel schneller.

- Ein agentenbasiertes LLM-Modell wäre in der Lage, die oben beschriebene Erstellung von Inhalten für größere Datenmengen in einem schneller, effizienter WegDas beinhaltet so etwas wie Menschenführung.

- Vor allem aber können Kriminelle dadurch schneller nach Zielen und Daten suchen, die sie ausnutzen können.

Anwendungsfall 2 - Optimierung der Zielgruppenansprache von hoher Qualität

- Böswillige Akteure könnten E-Mail-Adressen von einer Vielzahl von Unternehmen sammeln, indem sie LinkedIn oder andere Tools nutzen, um das E-Mail-Adressformat aus öffentlich zugänglichen Daten zu ermitteln.

- Sie können dann das Format nachahmen, um betrügerische E-Mails zu versenden, die scheinbar von Führungskräfte und ihre Untergebenen ins Visier nehmen.

Zweifellos ist die agentenbasierte KI ein Trend, den es zu beobachten gilt, denn die generative künstliche Intelligenz boomt.

Einpacken

Denken Sie daran, dass unzensierte LLMs und bösartige KI-Technologien nicht nur eine zukünftige Bedrohung sind - sie sind jetzt schon da und verändern alles, was wir über Cyberbedrohungen wissen. Um die Nase vorn zu haben, müssen Sie die Taktiken, die Tools und die unerbittliche Nutzung von KI-Innovationen durch Cyberkriminelle verstehen.

Möchten Sie mehr darüber erfahren, wie sich diese KI-Bedrohungen branchenübergreifend auswirken? Setzen Sie sich mit uns in Verbindung, um eine maßgeschneiderte Bedrohungsanalyse zu erhalten.

Sind Sie neugierig auf mehr Erkenntnisse? Lesen Sie unsere jüngste Analyse zu den KI-gestützten Phishing-Angriffen, "KI-gestütztes Phishing ist auf dem Vormarsch [Was ist zu tun?]."